یادگیری تقویتی عمیق چیست؟ (Deep Reinforcement Learning)

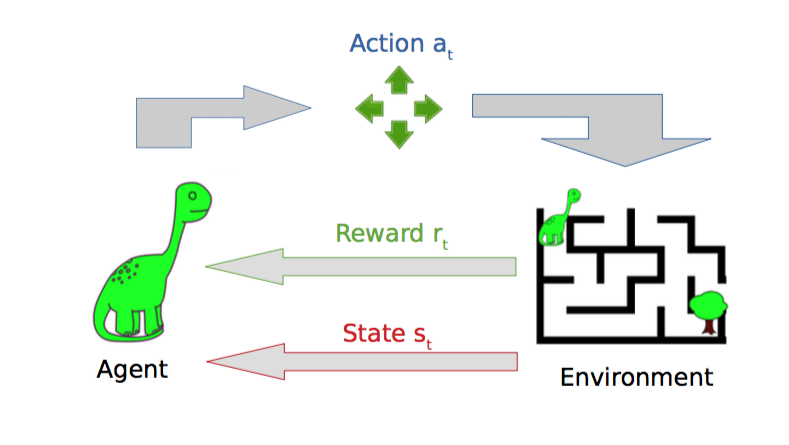

یادگیری تقویتی عمیق (Deep Reinforcement Learning یا DRL) یک روش هوش مصنوعی است که در آن یک عامل (Agent) از طریق آزمون و خطا و با کمک شبکههای عصبی عمیق یاد میگیرد بهترین تصمیم را در یک محیط پیچیده بگیرد.

این روش ترکیبی از دو حوزه بزرگ است:

- یادگیری تقویتی (Reinforcement Learning – RL)

یادگیری بر اساس پاداش و تنبیه - یادگیری عمیق (Deep Learning)

استفاده از شبکههای عصبی برای درک مسائل پیچیده

وقتی این دو کنار هم قرار میگیرند، هوش مصنوعی میتواند در محیطهایی عمل کند که:

- تعداد حالات بسیار زیاد است

- دادهها پیوستهاند

- رفتار از قبل مشخص نیست

- تصمیمگیری نیاز به هوش و تجربه دارد

برای همین DRL امروز در روباتیک، رانندگی خودکار، بازیها، پزشکی، مدلسازی مغز و… بسیار کاربرد دارد.

یادگیری تقویتی عمیق چگونه کار میکند؟

برای توضیح ساده، یک مثال بزنیم:

فرض کنید یک روبات میخواهد یاد بگیرد چگونه از یک مسیر پرمانع عبور کند.

اجزای اصلی:

۱- State – وضعیت محیط

روبات میبیند کجاست، موانع کجا هستند، سرعت چقدر است…

۲- Action – عمل

حرکت کند، بپیچد، بایستد، سرعت را زیاد یا کم کند…

۳- Reward – پاداش

- اگر به هدف نزدیک شود → پاداش

- اگر با مانع برخورد کند → تنبیه

Agent چه میکند؟

Agent تلاش میکند سیاست رفتاری (Policy) را یاد بگیرد؛ یعنی:

“در هر وضعیت، بهترین عمل چیست؟”

در RL قدیمی، این کار با جدول انجام میشد.

اما در مسائل واقعی، جدول جواب نمیدهد!

چرا؟

- وضعیتها پیوستهاند

- تعداد حالات بینهایت زیاد است

- رفتارها پیچیدهاند

اینجاست که شبکه عصبی عمیق وارد میشود.

نقش شبکه عصبی در یادگیری تقویتی عمیق

شبکه عصبی مانند یک مغز کوچک است که یاد میگیرد:

- وضعیت محیط را تحلیل کند

- ویژگیهای مهم را تشخیص دهد

- مقدار ارزش هر عمل را پیشبینی کند

به این کار تابع ارزش (Value Function) میگویند.

در واقع شبکه عصبی، به جای یک جدول بسیار بزرگ، تمامی حالتها و رفتارها را بهصورت تقریبی یاد میگیرد.

به همین دلیل یادگیری تقویتی عمیق میتواند:

- در محیطهای پیچیده کار کند

- اطلاعات ناقص را مدیریت کند

- رفتارهای جدید بسازد

- در موقعیتهای جدید تعمیم دهد

مثال عملی از DRL در زندگی واقعی

رانندگی خودکار

یک خودرو هوشمند باید:

- وضعیت جاده را درک کند

- سرعت و خط حرکت را تنظیم کند

- خطرات را پیشبینی کند

- در لحظه واکنش نشان دهد

تمام این رفتارها با ترکیب:

- بینایی ماشین (برای تشخیص محیط)

- یادگیری تقویتی عمیق (برای تصمیمگیری)

اتفاق میافتد.

یادگیری تقویتی عمیق در علوم اعصاب

در مقاله The Neurobiology of Deep Reinforcement Learning توضیح داده میشود که:

بسیاری از اصول یادگیری تقویتی عمیق شبیه عملکرد مغز انسان است.

مثلاً:

- دوپامین برای مغز همان نقش “پاداش» را دارد

- نورونها شبیه “شبکه عصبی مصنوعی» رفتار میکنند

- مغز هم مثل DRL در لحظه تصمیم میگیرد و از تجربه میآموزد

- مغز از “تنوع رفتاری» برای جستجوی گزینههای بهتر استفاده میکند (Exploration)

بنابراین DRL یک مدل بسیار خوب برای فکر کردن در مورد یادگیری انسان و حیوانات است.

مهمترین الگوریتمهای یادگیری تقویتی عمیق

برخی از مشهورترین الگوریتمها:

- DQN (Deep Q-Network)

- DDPG (برای اقدامات پیوسته)

- A3C و A2C

- PPO — پادشاه الگوریتمهای پایدار

- SAC — یادگیری با آنتروپی نرم

هرکدام مزایا و کاربردهای خاص خود را دارند.

جمعبندی

یادگیری تقویتی عمیق یکی از قویترین روشهای هوش مصنوعی است زیرا:

- از تجربه یاد میگیرد

- رفتارهای جدید میسازد

- محیطهای پیچیده را مدیریت میکند

- ساختاری مشابه مغز انسان دارد

این روش پایه بسیاری از فناوریهای مدرن است:

از روباتیک و بازیهای ویدئویی گرفته تا مدلسازی عصبی و خودروهای خودران.