قبل از هر توضیحی دقت کنید در این مقاله گاهی بهجای استفاده از عبارت یادگیری تقویتی سلسله مراتبی از مخفف آن یعنی HRL استفاده خواهیم کرد.

در حوزهی به سرعت در حال پیشرفت هوش مصنوعی (AI)، یادگیری تقویتی (Reinforcement Learning یا RL) به عنوان ابزاری قدرتمند برای حل مسائل پیچیدهی تصمیمگیری مطرح شده است. الگوریتمهای سنتی RL موفقیتهای چشمگیری در حوزههای مختلف، از بازیها تا رباتیک، نشان دادهاند. با این حال، با پیچیدهتر شدن وظایف، محدودیتهای روشهای مسطح RL آشکار میشود.

اینجاست که یادگیری تقویتی سلسله مراتبی (Hierarchical Reinforcement Learning یا HRL) وارد میشود و رویکردی ساختاریافته برای تجزیهی وظایف پیچیده به زیروظایف قابل مدیریت ارائه میدهد.

در این مقاله، به مفهوم HRL، اجزای کلیدی آن و نحوهی شکلدهی آن به آیندهی هوش مصنوعی میپردازیم.

فهرست مطالب

- یادگیری تقویتی سلسله مراتبی (HRL) چیست؟

- اجزای کلیدی یادگیری تقویتی سلسله مراتبی

- مطالعه موردی: H-DQN برای ناوبری ربات خودران

- رویکرد یادگیری تقویتی سلسله مراتبی: H-DQN

- پیادهسازی

- نتایج

- مزایای یادگیری تقویتی سلسله مراتبی

- کاربردهای یادگیری تقویتی سلسله مراتبی در هوش مصنوعی

- چالشها و جهتهای آینده

- نتیجهگیری

یادگیری تقویتی سلسله مراتبی (HRL) چیست؟

یادگیری تقویتی سلسله مراتبی (HRL) گسترشی از یادگیری تقویتی سنتی است که ساختار سلسله مراتبی را به فرآیند یادگیری اضافه میکند. برخلاف RL استاندارد، که در آن یک عامل (agent) یک سیاست (policy) را برای نگاشت مستقیم حالتها (states) به اقدامات (actions) یاد میگیرد، HRL به عامل اجازه میدهد تا چندین سطح از سیاستها را یاد بگیرد، که هر کدام مربوط به سطوح مختلفی از انتزاع (abstraction) هستند.

در HRL، وظایف به زیروظایف تجزیه میشوند و این زیروظایف در صورت لزوم میتوانند بیشتر تجزیه شوند. هر سطح از سلسله مراتب بر حل یک جنبهی خاص از وظیفهی کلی تمرکز میکند، که این کار یادگیری و بهینهسازی سیاستها را در سطوح مختلف انتزاع آسانتر میسازد. این رویکرد سلسله مراتبی نه تنها فرآیند یادگیری را سادهتر میکند، بلکه مقیاسپذیری و کارایی الگوریتمهای RL را نیز بهبود میبخشد.

اجزای کلیدی یادگیری تقویتی سلسله مراتبی

HRL بر اساس چندین جزء کلیدی ساخته شده است که ساختار سلسله مراتبی را ممکن میسازند:

- سیاستهای سلسله مراتبی: در HRL، سیاستها به صورت سلسله مراتبی سازماندهی میشوند، به طوری که سیاستهای سطح بالا تعیین میکنند کدام زیروظیفه یا سیاست سطح پایین باید فعال شود. سیاستهای سطح پایین بر دستیابی به اهداف خاص در چارچوب تعیینشده توسط سیاستهای سطح بالا تمرکز میکنند.

- چارچوب گزینهها (Options Framework): چارچوب گزینهها یک فرمالیسم محبوب در HRL است. یک گزینه از سه جزء تشکیل شده است: مجموعهی آغاز (initiation set)، یک سیاست، و یک شرط پایان (termination condition). مجموعهی آغاز تعیین میکند که چه زمانی میتوان گزینه را فراخوانی کرد، سیاست اقدامات لازم را تعیین میکند، و شرط پایان مشخص میکند که گزینه چه زمانی باید پایان یابد.

- کشف زیراهداف (Subgoal Discovery): شناسایی زیراهداف معنادار یک جنبهی حیاتی در HRL است. زیراهداف به عنوان نقاط عطف میانی عمل میکنند که عامل باید برای دستیابی به وظیفهی کلی به آنها برسد. کشف موثر زیراهداف میتواند عملکرد الگوریتمهای HRL را به طور قابل توجهی بهبود بخشد.

- شکلدهی پاداش (Reward Shaping): در HRL، شکلدهی پاداش شامل اختصاص پاداشها در سطوح مختلف سلسله مراتب برای هدایت فرآیند یادگیری عامل است. با ارائهی پاداشهای میانی برای دستیابی به زیراهداف، HRL میتواند همگرایی را تسریع و کارایی یادگیری را بهبود بخشد.

مطالعه موردی: H-DQN برای ناوبری ربات خودران

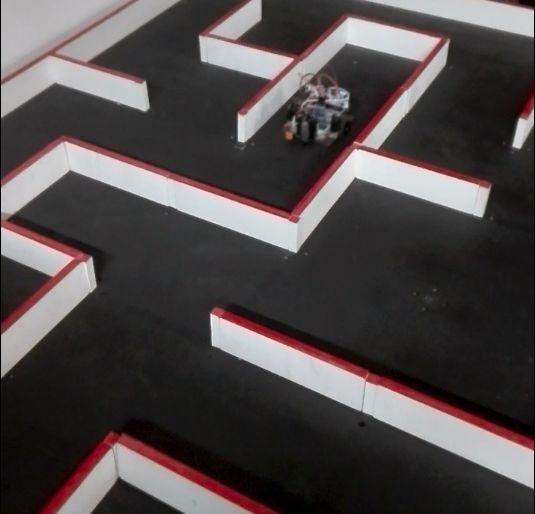

در این مطالعه، محققان از رویکرد یادگیری تقویتی سلسله مراتبی برای توانمندسازی یک ربات در ناوبری در محیطی شبیه به هزارتو استفاده کردند. هدف این بود که ربات به طور خودکار به یک موقعیت هدف برسد، در حالی که از موانع اجتناب میکرد و به طور موثر در محیط حرکت میکرد. ربات باید یاد میگرفت که چگونه در سطوح مختلف انتزاع تصمیمگیری کند، از برنامهریزی سطح بالا تا کنترل سطح پایین.

رویکرد یادگیری تقویتی سلسلهمراتبی: H-DQN

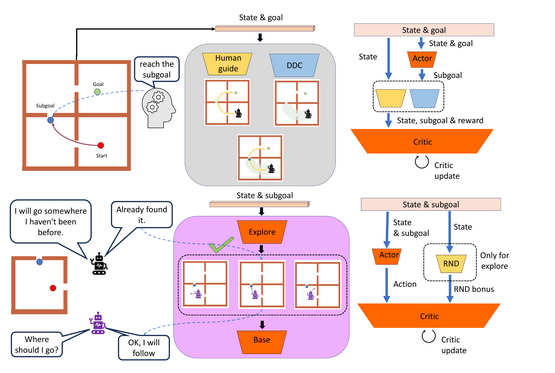

شبکهی عمیق Q سلسله مراتبی (H-DQN) مورد استفاده در این مطالعه یک مدل سلسله مراتبی دو سطحی است که شامل موارد زیر است:

- کنترلگر سطح بالا (Meta-Controller): کنترلگر سطح بالا مسئول انتخاب زیراهداف برای ربات بود. این زیراهداف حالتهای میانی بودند که ربات باید برای رسیدن به مقصد نهایی به آنها دست مییافت. کنترلگر سطح بالا در سطح انتزاعیتری عمل میکرد و بر استراتژی کلی برای ناوبری در محیط تمرکز داشت.

- کنترلگر سطح پایین (تحقق زیراهداف): کنترلگر سطح پایین مسئول دستیابی به زیراهداف تعیینشده توسط کنترلگر سطح بالا بود. این شامل کنترل دقیق حرکات ربات، مانند چرخش، حرکت به جلو و اجتناب از موانع در نزدیکی بود. کنترلگر سطح پایین از یک رویکرد استاندارد DQN (شبکهی عمیق Q) برای یادگیری این کنترلها استفاده میکرد.

پیادهسازی

- نمایش حالت (State Representation): حالت ربات با استفاده از ورودیهای سنسور، مانند LiDAR یا دوربینهای عمق، نمایش داده میشد که اطلاعاتی دربارهی محیط اطراف ربات، از جمله فاصلهها تا دیوارها و موانع، ارائه میکرد.

- ساختار پاداش (Reward Structure): تابع پاداش به صورت سلسله مراتبی طراحی شده بود. کنترلگر سطح بالا زمانی پاداش دریافت میکرد که ربات به یک زیرهدف که آن را به هدف نهایی نزدیکتر میکرد، دست مییافت. کنترلگر سطح پایین نیز برای اجرای موفق حرکاتی که به دستیابی این زیراهداف کمک میکرد، پاداش دریافت میکرد.

- آموزش (Training): H-DQN در یک محیط شبیهسازیشده آموزش داده شد که در آن ربات یاد میگرفت چگونه در هزارتوهای با پیچیدگی فزاینده ناوبری کند. با گذشت زمان، ربات درک میکرد که چگونه وظیفهی ناوبری را به زیراهداف تجزیه کند و چگونه اقدامات لازم برای دستیابی به این زیراهداف را به طور موثر اجرا کند.

نتایج

رویکرد H-DQN چندین مزیت کلیدی نسبت به روشهای سنتی RL مسطح نشان داد:

- ناوبری کارآمد: ربات توانست استراتژیهای پیچیدهی ناوبری را یاد بگیرد که به آن اجازه میداد به هدف خود به طور موثرتر برسد، از انحرافهای غیرضروری اجتناب کند و زمان رسیدن به مقصد را به حداقل برساند.

- مقیاسپذیری: ساختار سلسله مراتبی H-DQN به ربات اجازه داد تا به محیطهای بزرگتر و پیچیدهتر مقیاسپذیر شود بدون اینکه زمان آموزش یا منابع محاسباتی به طور قابل توجهی افزایش یابد.

- قابلیت انتقال: سیاستهای سطح بالایی که توسط کنترلگر سطح بالا یاد گرفته شده بود، در محیطهای مختلف با چیدمان مشابه قابل انتقال بود، که نیاز به آموزش مجدد را کاهش میداد.

مزایای یادگیری تقویتی سلسله مراتبی

HRL چندین مزیت نسبت به رویکردهای سنتی RL مسطح ارائه میدهد:

- مقیاسپذیری: با تجزیهی وظایف پیچیده به زیروظایف کوچکتر و قابل مدیریت، HRL مقیاسپذیری الگوریتمهای RL را بهبود میبخشد. این تجزیهی سلسله مراتبی امکان کاوش و یادگیری موثرتر در فضاهای بزرگ حالت-عمل را فراهم میکند.

- قابلیت انتقال: HRL انتقال دانش بین وظایف مختلف را تسهیل میکند. هنگامی که یک زیروظیفه یاد گرفته میشود، سیاست مربوطه میتواند در وظایف دیگری که شامل زیروظایف مشابه هستند، مجددا استفاده شود. این قابلیت انتقال نیاز به یادگیری از ابتدا در محیطهای جدید را کاهش میدهد.

- بهبود کارایی یادگیری: ساختار سلسله مراتبی HRL یادگیری موثرتر را با تمرکز بر زیروظایف خاص امکانپذیر میکند. این یادگیری هدفمند پیچیدگی فضای مسئله را کاهش میدهد و همگرایی الگوریتم یادگیری را تسریع میکند.

- قابلیت تفسیر بهتر: سازماندهی سلسله مراتبی سیاستها در HRL درک و تفسیر فرآیند تصمیمگیری عامل را آسانتر میکند. هر سطح از سلسله مراتب مربوط به سطح متفاوتی از انتزاع است، که بینشی دربارهی نحوهی رویکرد عامل به وظیفهی کلی ارائه میدهد.

کاربردهای یادگیری تقویتی سلسله مراتبی در هوش مصنوعی

HRL در حوزههای مختلفی که نیاز به تصمیمگیری پیچیده دارند، کاربرد پیدا کرده است:

- رباتیک: در رباتیک، HRL برای تجزیهی وظایفی مانند ناوبری، دستکاری اشیا و رانندگی خودران به زیروظایف کوچکتر استفاده میشود. این رویکرد به رباتها اجازه میدهد رفتارهای پیچیدهتر را به طور موثرتر یاد بگیرند و با محیطهای جدید سازگار شوند.

- پردازش زبان طبیعی (NLP): HRL در وظایف NLP مانند سیستمهای گفتگو به کار میرود، جایی که عامل باید چندین سطح از مکالمه را مدیریت کند، از درک هدف کاربر تا تولید پاسخهای مناسب.

- بازیها: در بازیهای ویدیویی، HRL برای ایجاد عاملهای هوش مصنوعی که میتوانند استراتژیهای پیچیده را با تجزیهی اهداف بازی به اهداف کوچکتر مدیریت کنند، استفاده میشود. این امر باعث ایجاد رفتارهای پیچیدهتر و شبیهتر به انسان در شخصیتهای کنترلشده توسط هوش مصنوعی میشود.

- سلامت: HRL در حوزهی سلامت برای وظایفی مانند برنامهریزی درمان شخصیسازیشده مورد بررسی قرار گرفته است، جایی که هدف کلی مراقبت از بیمار به مراحل کوچکتر و قابل مدیریت تقسیم میشود، که منجر به استراتژیهای درمانی موثرتر میشود.

چالشها و جهتهای آینده

علیرغم مزایای آن، HRL چالشهایی نیز دارد:

- کشف زیراهداف: شناسایی خودکار زیراهداف معنادار همچنان یک چالش بزرگ در HRL است. رویکردهای فعلی اغلب به دانش دامنه یا مداخلهی دستی متکی هستند، که این امر تعمیمپذیری الگوریتمهای HRL را محدود میکند.

- پیچیدگی سیاستهای سلسله مراتبی: طراحی و یادگیری سیاستهای سلسله مراتبی میتواند از نظر محاسباتی پرهزینه باشد و نیاز به تنظیم دقیق داشته باشد. تعادل بین پیچیدگی سیاست و کارایی یادگیری یک حوزهی تحقیقاتی در حال پیشرفت است.

- ادغام با یادگیری عمیق: ادغام HRL با تکنیکهای یادگیری عمیق یک جهتگیری امیدوارکننده است، اما چالشهایی مانند مدیریت نیازهای محاسباتی افزایشیافته و اطمینان از یادگیری پایدار را نیز به همراه دارد.

نتیجهگیری

یادگیری تقویتی سلسله مراتبی (HRL) یک گسترش قدرتمند از یادگیری تقویتی سنتی است که رویکردی ساختاریافته برای مقابله با وظایف پیچیده ارائه میدهد. با تجزیهی وظایف به زیروظایف و سازماندهی سیاستها به صورت سلسله مراتبی، HRL مقیاسپذیری، کارایی یادگیری و قابلیت تفسیر را بهبود میبخشد. با پیشرفت تحقیقات در حوزهی HRL، میتوان انتظار داشت که کاربردهای آن در حوزههای مختلف گسترش یابد و قابلیتهای سیستمهای هوش مصنوعی را بیشتر کند.

منبع: https://www.geeksforgeeks.org/hierarchical-reinforcement-learning-hrl-in-ai/